Bloomberg — O fundador da Wikipedia disse que não está preocupado com a ameaça que o conteúdo gerado por IA representa para a enciclopédia on-line gratuita, incluindo a Grokipedia de Elon Musk, devido ao fato de que as informações tendem a ser propensas a erros.

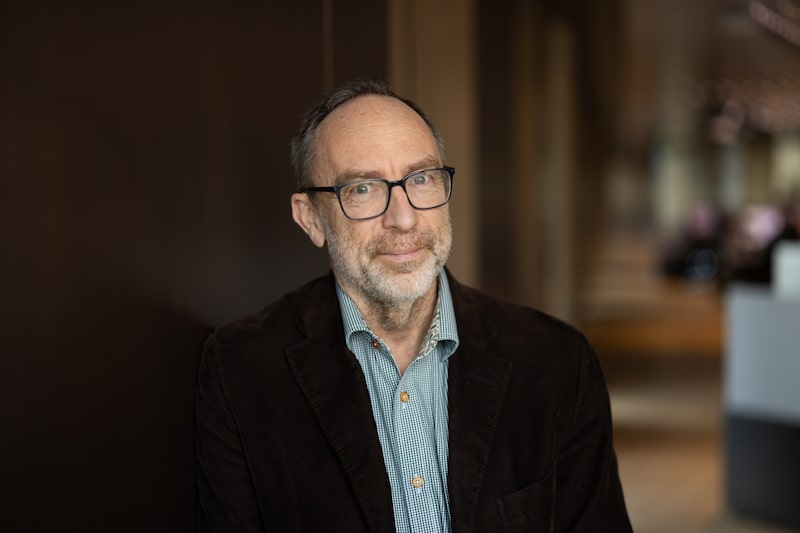

“Por que eu vou à Wikipedia? Eu vou à Wikipedia porque é um conhecimento verificado por humanos”, disse Jimmy Wales, fundador da popular enciclopédia da internet, cujos artigos são escritos e editados por voluntários humanos.

“Não pensaríamos nem por um segundo em permitir que uma IA escrevesse artigos da Wikipedia, pois sabemos como eles podem ser ruins. Portanto, acho que isso não é realmente uma preocupação.”

Leia também: ‘Velocidade e aceleração’: Musk reestrutura equipe da xAI após saída de cofundadores

Segundo ele, um dos problemas com os resultados de grandes modelos de linguagem, como o ChatGPT da OpenAI e o Gemini da Alphabet, é a alta frequência com que eles ainda geram “alucinações”, ou seja, informações errôneas ou enganosas.

É por essa razão que ele não está preocupado com a concorrência de rivais como a Grokipedia, uma enciclopédia on-line gerada por IA lançada no ano passado pela xAI de Musk, que ele chamou de “imitação caricatural de uma enciclopédia”.

Wales fez os comentários em uma entrevista à Bloomberg News à margem do India AI Impact Summit em Nova Délhi, um evento que atraiu mais de uma dúzia de chefes de estado e funcionários de tecnologia da OpenAI, Alphabet, Anthropic e outros.

Leia também: Por que a Microsoft admitiu que a IA pode deixar as pessoas menos inteligentes

As alucinações com IA se tornam mais flagrantes e comuns à medida que o assunto se torna mais obscuro ou de nicho, disse Wales. O valor dos artigos gerados por seres humanos é que eles se beneficiam das contribuições de especialistas no assunto, o que ajuda a evitar imprecisões e gera artigos mais bem informados, disse ele.

“As pessoas são obsessivas”, disse ele. “Esse tipo de contexto humano completo e rico de compreensão é, na verdade, muito importante em termos de realmente entender o que o leitor quer e o que o leitor precisa.”

Um estudo realizado em 2025 pela OpenAI constatou que as alucinações ainda eram comuns até mesmo em seus modelos avançados, com taxas de alucinação de até 79% em alguns testes.

Leia também: Cofundador da Wikipédia critica obsessão por engajamento nas redes sociais

“O problema da alucinação piora quanto mais obscuro for o tópico e, portanto, para áreas em que você poderia pensar que precisaríamos de ajuda, na verdade é muito, muito ruim”, disse Wales.

Veja mais em bloomberg.com

©2026 Bloomberg L.P.